闻达:一个大规模语言模型调用平台

闻达,一个为个人与中小企业设计的大规模语言模型调用平台,集成多种功能以支持高效的内容生成和知识管理。

直达下载

回到上一页

介绍

闻达是一个专门针对特定环境高效内容生成的平台,旨在解决个人和中小企业在计算资源有限、知识安全和私密性方面的需求。该平台通过集成多种功能,支持用户在有限的资源下实现高效的内容生产和知识管理。

平台核心能力

闻达平台的主要功能如下:

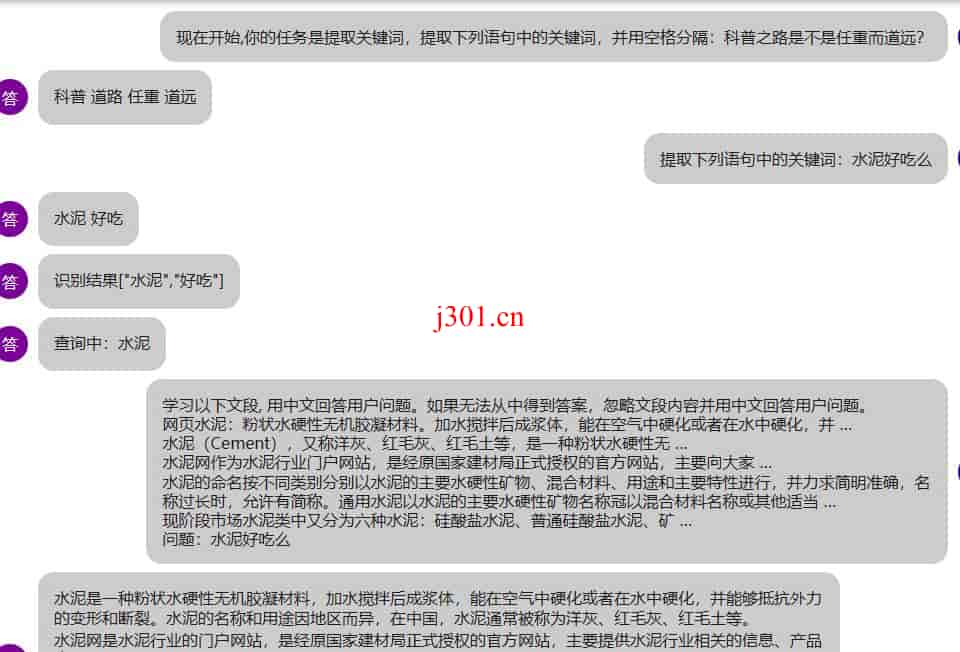

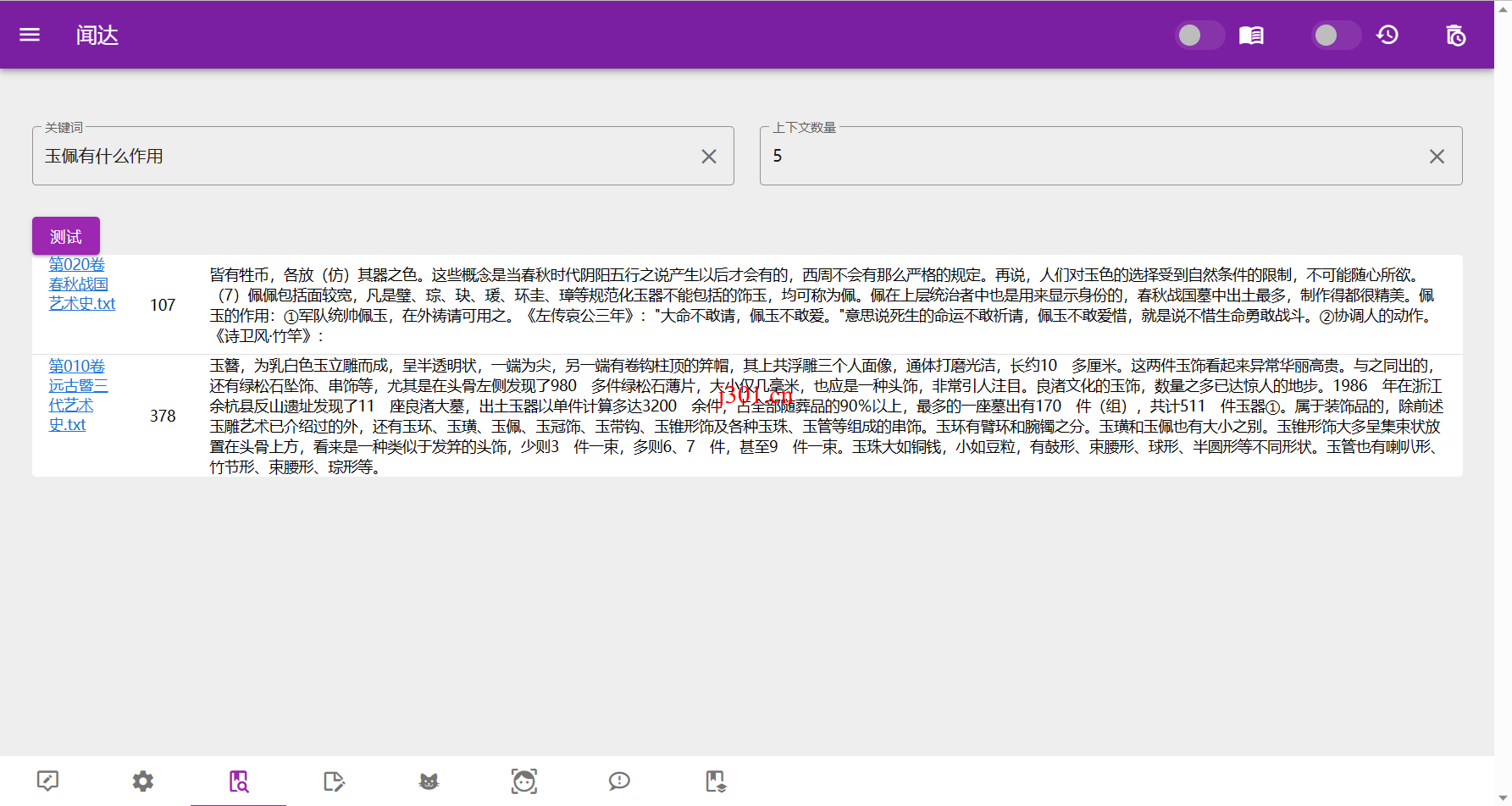

- 知识库集成:支持接入本地离线向量库、本地搜索引擎以及在线搜索引擎,便于进行丰富和灵活的数据检索与管理。

- 多语言模型支持:包括离线部署的模型(如chatGLM-6B, chatGLM2-6B, chatRWKV等)和在线API访问模型(如openai api, chatGLM-130b api),以及专为中文用户设计的llama系列和moss。

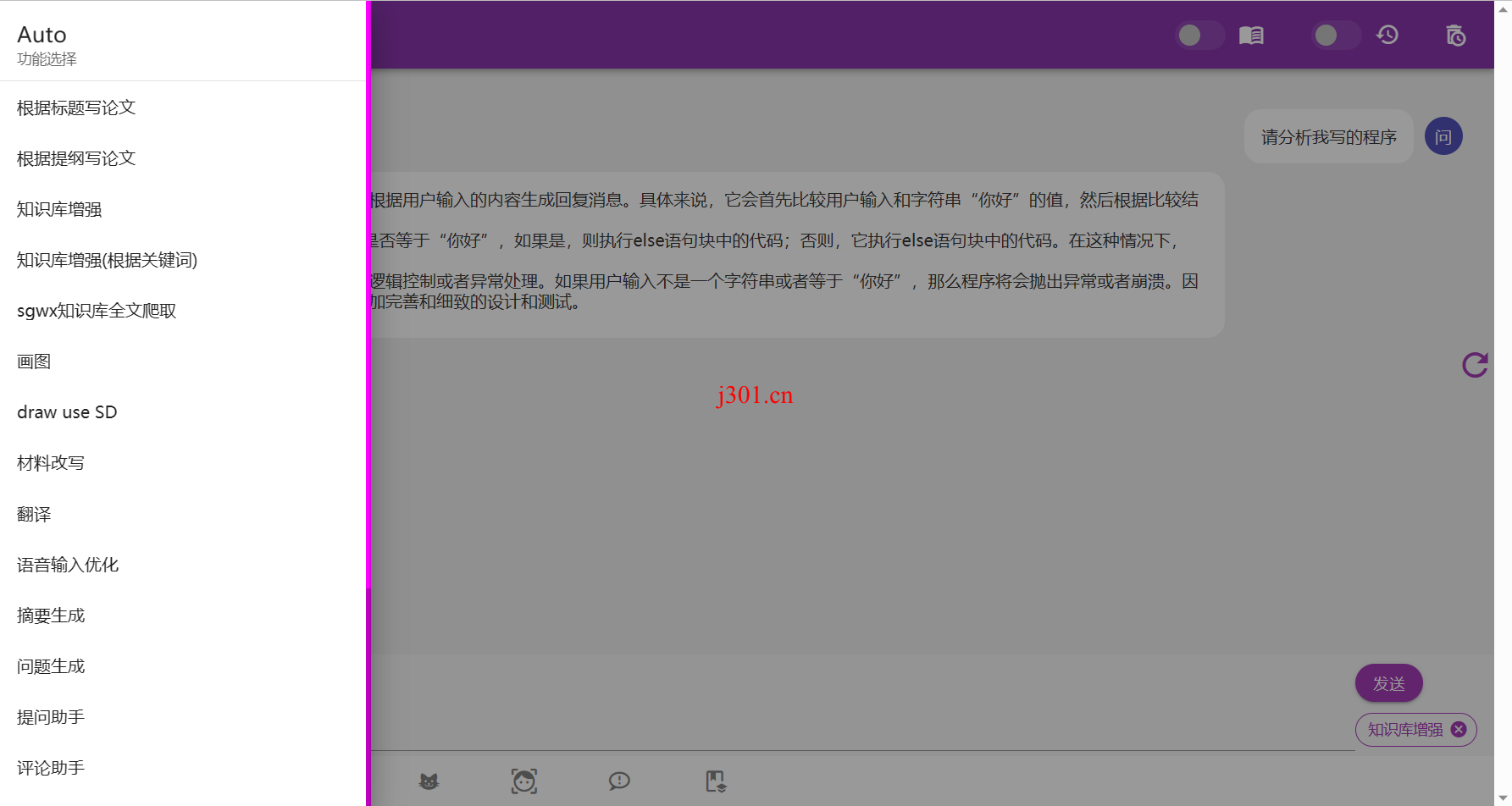

- Auto脚本插件:用户可以通过JavaScript开发插件形式的脚本,为平台添加如自定义对话流程、API调用等附加功能。

- 实用功能:包括对话历史管理、内网部署和多用户并行使用等,确保平台的高效运行和用户的数据安全。

安装与部署

1. 各模型功能说明

- chatGLM-6B/chatGLM2-6B:支持多用户并行、流式输出,需要GPU支持且可外挂LoRA。

- RWKV:支持CPU和GPU,提供量化加速选项。

- Baichuan-7B:支持多用户并行,流式输出,适合CPU和GPU使用。

- Aquila-7B:尚未实现官方流式输出,支持GPU。

2. 懒人包下载

点击上方的直达下载按钮即可下载。

使用步骤例如使用glm6b模型包括:下载、安装CUDA、运行批处理脚本等。

3. 自行安装

- 安装依赖:根据使用的功能配置相关的库。

- 下载模型:选择合适的模型进行下载,配置模型参数。

自定义与开发

闻达平台的Auto功能允许用户通过JavaScript脚本自定义扩展功能,如自定义对话流程和动态知识库的查询等。以下是一些Auto脚本的开发示例:

- 发送信息:

send(s, keyword = "", show=true)发送信息至模型并接收返回。 - 添加会话信息:

add_conversation(role, content)允许添加自定义的对话内容。 - 知识库查找:

find(s, step = 1)和find_dynamic(s, step=1, paraJson)从知识库查找信息。

知识库管理

闻达的知识库功能支持多种模式,如rtst模式、bing模式和fess模式,用户可以根据需求选择合适的知识库模式进行内容的检索和管理。此外,还提供了知识库清洗工具,帮助用户维护和优化知识库的数据质量。

闻达平台为个人和中小企业提供了一个高效、灵活的大规模语言模型调用解决方案,特别注重计算资源的优化使用和数据的安全性,是进行高效内容生成和知识管理的理想选择。

×

直达下载