VisualGLM-6B:一款新型多模态对话模型

介绍VisualGLM-6B,一款新型的多模态对话语言模型,包括其特点、应用及未来优化方向。

直达下载

回到上一页

介绍

智谱AI最新推出的多模态对话模型CogVLM吧!这款模型在10个权威的多模态任务上荣登榜首,全部归功于它的新颖视觉专家架构。现在,英文版的CogVLM-17B已经开源,不久后还会有基于GLM的中文版模型发布。

模型详解

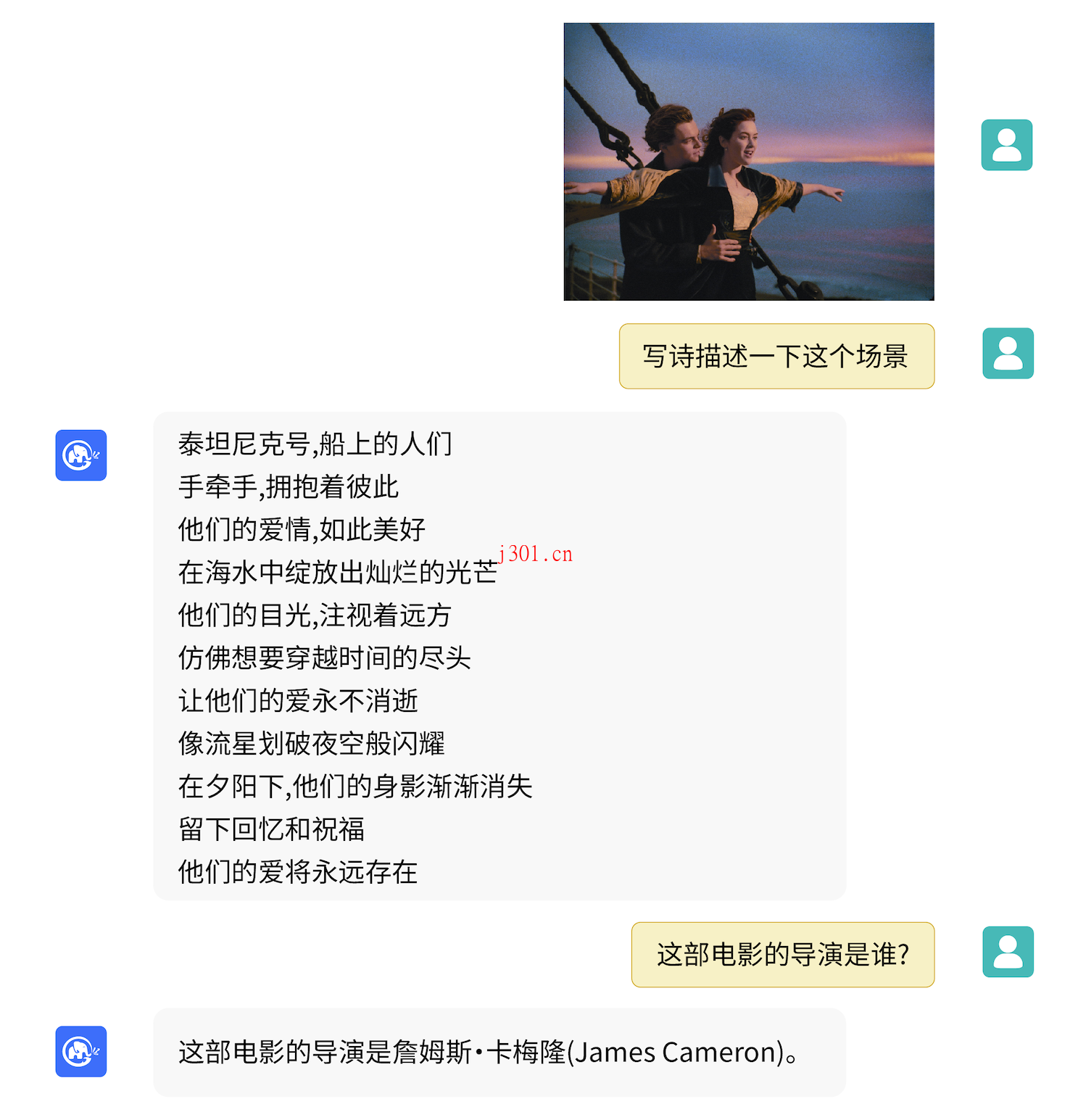

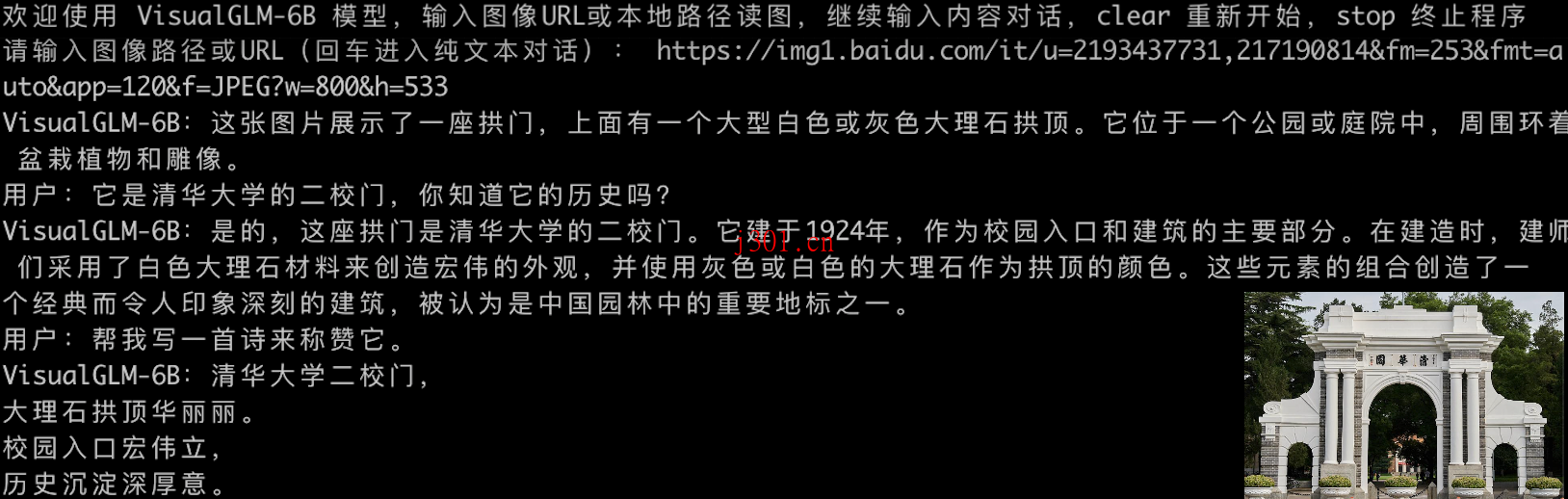

VisualGLM-6B是一个支持图片、中文和英文的开源多模态对话语言模型。它基于拥有62亿参数的ChatGLM-6B,而图像部分则通过BLIP2-Qformer的训练,使得整体模型参数达到78亿。这样的设计让视觉信息和语言信息能够更加无缝地融合,为各种应用提供了一个强大的平台。

训练优化过程

VisualGLM-6B使用来自CogView数据集的3000万高质量中文图文对,以及300M经过筛选的英文图文对进行预训练,确保了中英文处理的均衡性。这种训练方式不仅优化了视觉信息与ChatGLM语义空间的对齐,还在微调阶段针对长视觉问答数据进行了优化,使模型能够生成更符合人类偏好的答案。

部署与应用

借助模型量化技术,用户可以在消费级的显卡上本地部署VisualGLM-6B(INT4量化级别下,显存需求最低为6.3G)。开源模型的推出,旨在推动大模型技术的发展,并呼吁开发者共同遵守开源协议,避免将模型用于可能危害社会和国家安全的用途。

尽管VisualGLM-6B在多模态任务中展现出了不俗的表现,但模型仍处于v1版本,存在一些诸如图像描述的事实性不足、模型幻觉问题等局限性。团队将在后续版本中继续优化这些问题,以实现更精准和可靠的模型表现。

×

直达下载